¿Un modelo a seguir?

Sin duda alguna, la inteligencia artificial (en adelante IA) atraviesa muchos aspectos de nuestra vida cotidiana y ofrece innumerables ventajas en distintas áreas como las finanzas, el derecho, el comercio, la medicina mediante la automatización de procesos rutinarios, búsqueda de información, generación de textos, imágenes y videos, asistentes virtuales, domótica y tantas otras aplicaciones. También conlleva riesgos y efectos secundarios que requieren la adopción de medidas de prevención y de minimización de los mismos.

Desde el año 2018, la Unión Europea (en adelante, UE) ha elaborado una estrategia en materia de IA elaborando documentos y resoluciones que contienen directrices éticas para una IA fiable. Este largo y arduo proceso culminó con el dictado de la denominada Ley de Inteligencia Artificial que constituye el marco regulatorio con el cual la UE pretende poner en práctica los principios rectores generados durante todos estos años para el desarrollo de una IA homocéntrica. La misma entrará en vigencia en 2026.

La definición que se adopta sobre sistema de IA hace referencia al software que opera de manera autónoma y que, con la información introducida por seres humanos u otros sistemas, es capaz de generar contenido como respuestas, recomendaciones o decisiones alcanzadas mediante técnicas de lógica o machine-learning. Vemos que esta definición dista de aquella tradicional dado que agrega el elemento de la autonomía y por ello, es necesario establecer pautas claras y efectivas.

Uno de los aspectos más relevantes de la norma es la clasificación de niveles de riesgo en función de las características y funcionalidades de la IA estableciendo limitaciones o restricciones de acuerdo al mismo y diferentes obligaciones a desarrolladores y prestadores.

Riesgo inaceptable: Implica la prohibición de sistemas en los que por perfilamiento de comportamiento, identificación biométrica, explotación de vulnerabilidades y otros, puedan causar daños físicos o psicológicos a las personas, ser objeto de discriminación o trato desfavorable o sean una clara amenaza para la seguridad, los medios de subsistencia y los derechos de los usuarios.

Riesgo alto: Se encuentran permitidos sujetos a determinadas normas como son los sistemas de IA cuyo uso sea relevante para la salud, seguridad o derechos fundamentales, gestión de infraestructuras críticas como tráfico, electricidad o agua, gestión del acceso a la educación o planificación del desarrollo académico, selección de personal y gestión de relaciones laborales, actividades de fuerzas de seguridad, migración, asilo y control de fronteras, entre otros.

Riesgo mínimo o sin riesgo. Se permiten dichos sistemas de IA sin restricciones.

Además de establecer esta clasificación, la ley en análisis regula el ámbito de aplicación, las obligaciones de proveedores, usuarios, importadores y distribuidores de IA, un régimen de sanciones muy riguroso y toda otra regulación tendiente a cumplir con el objetivo de una IA fiable, transparente, inclusiva, sostenible y al servicio de la humanidad.

¿En qué estado del arte nos encontramos en nuestro país? ¿Puede ser adoptada como modelo esta normativa de la UE?

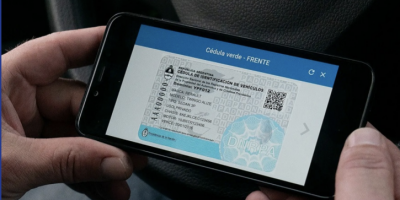

En 2023, Argentina aprobó las “Recomendaciones para una Inteligencia Artificial Fiable” con el propósito de garantizar el desarrollo responsable y beneficioso de la IA. El documento toma como antecedentes las recomendaciones sobre la ética de la Inteligencia Artificial de OCDE y UNESCO, entre otros.

Otro avance es el proyecto de modificación de la Ley 25467 relativa al Sistema de Ciencia, Tecnología e Innovación que tiene como fin regular el funcionamiento ético de los sistemas de Inteligencia Artificial (IA) los que deberán estar regidos por los valores y principios de diversidad, inclusión, paz y justicia.

En conclusión, la Ley de Inteligencia Artificial de la UE podría ser un modelo para Argentina en términos de regulación y gobernanza de la IA dado que adopta estándares internacionales similares a los principios que se encuentran presentes en las recomendaciones dadas a conocer por nuestro país en 2023.

Por otra parte, regular la IA con un enfoque similar al de la UE, facilitaría la cooperación internacional y la armonización de normas además de promover una innovación responsable, inclusiva y, sostenible que proteja los derechos y libertades fundamentales de las personas

(*) Silvia Susana Toscano, abogada (UBA), Magister en Administración Pública (UBA), especialista en derecho y tecnología, miembro del Instituto de Filosofía Política e Historia de las Ideas Políticas de la Academia Nacional de Ciencias Morales y Políticas, miembro del Grupo de Trabajo de Políticas Digitales y Ciberseguridad del Consejo Argentino para las Relaciones Internacionales (CARI), docente en universidades nacionales e internacionales, expositora y autora en temas de su especialidad. Ex funcionaria del Ministerio de Justicia y Derechos Humanos de la Nación.